Neue IT-Betriebskonzepte

IT Lösungen kosten Geld. Meist ist nicht die Software-Entwicklung der Kostentreiber, sondern der Betrieb von IT-Lösungen. Kostenkontrolle ist in aller Munde, und gespart werden soll immer.

Andererseits verfallen nicht nur die Preise für Hardware, sondern auch Server in kommerziellen Rechenzentren wird immer preisgünstiger. Dieser Trend kommt bei den Firmen oft nicht an. Dabei bestehen hier große Potenziale zu einer günstigeren Betriebsorganisation.

Stichworte: Economies of Scale, Standardisierung, Konzentration aufs Kerngeschäft.

Warum ist IT in vielen Unternehmen so teuer?

Kann man nicht heftig auf die Kostenbremse treten?

Die Gründe, die Profis oft anführen, warum die Betriebskosten eines Servers mehrere Tausend Euro je Monat sei, und die Angebote für günstige Miet-Server nicht vergleichbar sei, sind folgende:

- Sicherheit: Unternehmensdaten benötigen Schutz vor missbräuchlicher Nutzung.

- Betriebssicherheit ... gegen technische Störungen. Einschließlich ausgereifter Datensicherungsmethoden.

- Leistung und Flexibilität: Die angebotenen Server entsprächen nicht den Anforderungen des Unternehmens.

- Betreuung: Die Hauptkosten liegen im Personal, dass eben bedarfsgerecht vorzuhalten ist.

- Softwarelizenzen für das Systemmonitoring: Profi-Werkzeuge sind sehr teuer.

- Gesetzliche Anforderungen: Sonderauflagen und Gesetze zwingen zu einer Kontrolle über die Datenhaltung.

- Psychologie: Die Unternehmensleitung möchte sehen, wo ihre sensiblen Daten stehen.

All das mag im Einzelfall auch tatsächlich ein Faktor gegen ein Server-Outsourcing sein. Häufig trifft es allerdings nicht zu, dererlei Argumente gegen massive Kosteneinsparung anzubringen, denn auf die unterschiedlichen Herausforderungen finden häufig auch gute Antworten seitens kommerzieller IT-Anbieter. Siehe unten ...

Paradigmen und IT-Landschaften

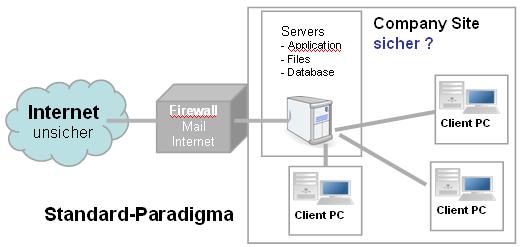

Meist schwebt mehr oder minder bewusst das Bild eines Unternehmens an einem Standort im Hinterkopf. Außerhalb des Gebäudes oder des Campus ist dann die unsichere Außenwelt, in der die Gefahren lauern.

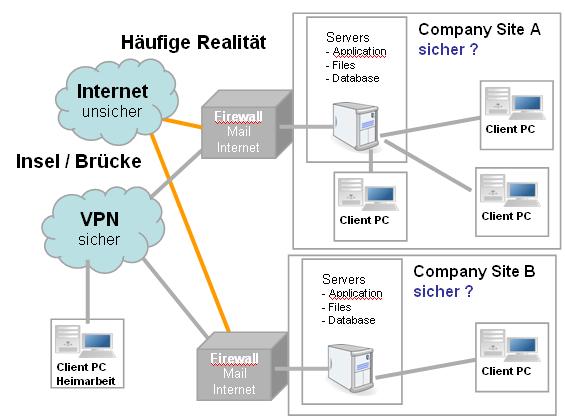

Aber auch bereits bei kleineren Unternehmen hat dieses Bild Risse bekommen: Verteilte Standorte und Heimarbeitsplätze, Unterstützung des Außendienstes usw. zersiebt das Bild der heilen Welt in sicheren Mauern. Mittels technischer Einrichtungen - Früher: ISDN-Einwahl, heute: VPN - versucht man dieses Bild in erweitertem Rahmen aufrecht zu erhalten.

Allerdings ist nicht erst seit der Lichtensteiner CD bekannt, dass die meisten Fälle von Sicherheitsverstößen nicht durch raffinierte Hacker jenseits der Firewalls und Spionageorganisationen geschehen, sondern durch eigene Mitarbeiter in Firmennetzen. Eine andere Sicht bei der Beurteilung der Risiken ist erforderlich, denn eine neurotische Angst vor bestimmten Gefahren bei gleichzeitiger Blindheit gegen andere Bedrohungen ist sicher nicht besonders rational. Vielmehr gilt es, zu einer vernünftigen Beurteilung von sinnvollen Schutzmaßnahmen zu kommen ohne sich mit der Adressierung seltener Risiko-Szenarien zu verlieren.

Merke: Die Sicherheit und den Datenbesitz an eine physische Lokation zu binden ist nur eine Fata Morgana - ein Hilfskonstrukt, dass schon lange die Realität nicht mehr gültig beschreibt.

Treffender ist das Bild von Services und Rechten, die die eigentliche Substanz ausmachen, die Implementierung auf Rechnern, Datenträgern und Netzen ist lediglich deren Abbildung in der Realität. Hier wird Platons Höhlengleichnis aktuell: Die wirklichen Dinge sind die Ideen, was wir sehen, sind nur die Schatten dieser. Die IT der neuen Entwicklung ist nicht mehr der Server und die Hardware (die sind nur die Schatten der Ideen), sondern das Konzept, die Dienste und Rechte. Programme und Daten kann man nicht mit Händen greifen. Nur werden die Konsequenzen oft nicht verdaut. Man glaubt oft immer noch: IT ist doch was zum Anfassen ...

In diesem Sinne war bereits vor 5 Jahren eine erste Welle neuer Konzepte unter dem Namen ASP - Application Service Provider - über den Markt gerollt und verpufft. Zu diesem Zeitpunkt war die Infrastruktur mit nahezu flächendeckenden schnellen DSL-Verbindungen und Flatrates noch nicht vorhanden. Die Idee war zu innovativ, als das es eine hinreichende Akzeptanz gefunden hätte.

Nun erleben wir unter dem Schlagwort Software as a Service (SaaS) einen neuen Anlauf. Und iesmal scheint es auch breitere Unterstützunmg zum Thema zu geben. Siehe SaaS-Forum: Lösungskatalog

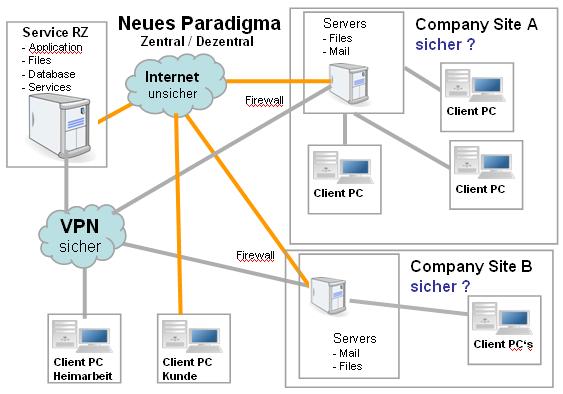

Hier gehe ich einen ähnlichen, aber anderen Weg: Warum die Einzelnen Komponenten einzeln zusammen bauen? Warum nicht eine komplette Plattform nutzen in einem VPN, dass seine Mitte in einem Servic-DataCenter hat? Gegebenenfalls kann dann ein SaaS Produkt ergänzend hinzu genommen werden.

Doch zunächst eine Differenzierung nach Kategorieen der IT-Anwender:

Kleine Firmen

haben oft einen oder mehrere Server in einem Server-Raum, der zuweilen nicht klimatisiert ist, keine USV, keine IT-gerechte Löscheinrichtung und Zutrittskontrolle ... und über keine Ausfall-Szenarien verfügt. Oft bestehen Band-Sicherungen, die recht und schlecht organisiert sind und im Fehlerfall oft zu unangenehmen Überraschungen führen. Man geht oft die Risiken ein mit Hinweis auf die hohen Kosten, die eine ausgereifte sichere Lösung kosten würde. Auch ist das Betreuungspersonal meist nicht 'redundant': Ist der Administrator krank oder in Urlaub, kann es zu unerwünschten Wartezeiten kommen. Kurioser Weise sind diese Lösungen oft wesentlich teurer als Miet-Server-Lösungen, die in fast allen Bereichen besser abschneiden. Üblicherweise sitzt man den Versprechungen der Hardware-Herstellern auf, ohne die Konsequenzen der Betreuung und Infrastruktur zu durchdenken. Dagegen sind bereits passable Server ab etwas Euro 100 im Monat in einem Rechenzentrum zu mieten.

In der Regel wissen aber die Entscheider kleiner und mittlerer Unternehmen nicht, was und wo Kosten in IT-Lösungen stecken und welche Potenziale realisiert werden könnten, wie wohl eine Risiko-Betrachtung unterbleibt. Ein Controlling ist meist unzureichend vorhanden, oder aber es ist rein kostenrechnerisch aufgestellt, oder technisch-punktuell orientiert. Eine organisatorische Sicht, die die Prozesse sowohl aus Kostenperspektive, als auch aus technischer Sicht unter Bewertung der Risiken zusammen liefert, fehlt oft. Detailoptimierungen sind zu finden, aber der Mangel ist im Ganzen.

Das Potenzial von Verbesserungen liegt bei Kleinunternehmen vor allem in der Minimierung der Risiken und Verbesserung der Servicequalität. Mitunter können auch dramatische Kostensenkungen erwartet werden.

Konzerne

betreiben oft eigene Rechenzentren, nach allen Regeln der Kunst. Allerdings ist der Weg der Standardisierung hier bereits anzutreffen. Nicht selten sind Hunderte von Rechnern oder im Rahmen von Server-Konsolidierung - partitionierte Großrechner - im Einsatz. Die Kosten eines derartigen Servers ist oft aber abschreckend hoch. Es bleiben trotz eines Immensen Aufwandes immer noch Sicherheitslücken übrig, dass die Service-Qualität weit hinter den Erwartungen zurück bleibt.

Dies hat auch seinen Grund in der gewachsenen Struktur und der inneren Dynamik von IT-Fürstentümern. Durch verfestigte Strukturen in Unternehmen werden oftmals pfiffige und kostengünstige Lösungen nicht gewählt.

Gerade die Standardisierung erweist sich oft als Hürde: Die Messlatte wird an vielen stellen so hoch gelegt, dass die angestrebten Prozesse kontraproduktiv wirken und die Kosten treiben, anstelle sie zu senken. So kann eine neue Anwendung, die an sich wenig Ressourcen benötigt, oft nur auf einem dedizierten Standard-Server eingeplant werden, der dann wieder abschreckend hohe Kosten verursacht.

Auch ist die Betreuungsrealität oft weit ab von den nach verabschiedeten Prozessen. An manchen Stellen ist die geforderte Trennung von Entwicklung, Support und Betrieb nicht sachgerecht und führt nur zu hohen Reibungsverlusten.

Das Potenzial von Verbesserungen liegt bei Großunternehmen vor allem in der Kostensenkung und Flexibilisierung. Mitunter können sogar Verbesserungen im Bereich Sicherheit erwartet werden.

Angebote von Service-Rechenzentren

Doch bevor ein Betriebskonzept klar umrissen wird, welches sowohl von kleinen, als auch von großen Unternehmen genutzt werden könnte, hier ein Thematisieren der technischen Argumente die gegen die Nutzung eines Service-Rechenzentrum vorgetragen werden.

Als Service-Rechenzentrum wird hier ein Anbieter verstanden, der seine Dienste u.A. als Bereitsteller von Mietservern mit schnellen Internet-Anbindungen zu kostengünstigen Standard-Paketen schnürt. Durch die Konkurrenz der Service-Rechenzentren sind diese Anbieter gezwungen gewesen, effektive und kostengünstige Pakete zu schnüren.

Sicherheit

Unternehmensdaten benötigen Schutz vor missbräuchlicher Nutzung

Sicherheit ist ein großes Thema. Das Internet als öffentliches Netz gilt als besonders anfällig. Allerdings gibt es bereits ausgereifte Methoden des Schutzes: Firewalls und VPN - Virtual Private Networks mit robuster Verschlüsselung - lassen sich auch in Rechenzentren hervorragend betreiben. Sicher erfordert die Administration dieser Einrichtungen auch ein Mehraufwand gegenüber einfacher Web-Anwendungen. Allerdings sind die Grundaktivitäten wegen der ohnehin verteilten Lokationen oft schon vorhanden. Für neue Einrichtungen kommen neben zahlreichen kommerziellen Lösungen auch als Open Source Lösung OpenVPN oder SSL-VPN in Betracht. Als Nutzen kann davon ausgegangen werden, dass das Risiko gegen externe Hacker keineswegs höher ist als bei einem unternehmensinternen Rechenzentrum.

Oft werden dagegen bei unternehmensinternen Lösungen unsichere Verfahren mit erheblichen Lücken verwendet (z.b. Telnet, FTP usw.), weil man ja den Mitarbeitern vertraut. Dabei ist erwiesen, dass die Mehrzahl von Sicherheitsverstößen nicht durch externe Hacker, sondern durch Mitarbeiter geschehen. Im Zuge der generellen Nutzung von VPN's werden alle Daten über die Netze verschlüsselt und sind per se dadurch besser gegen Missbrauch geschützt.

Der Zugang zu den Service-Rechenzentren ist in der Regel streng geregelt. Er entspricht meist hochwertigen Konzernverfahren zur Zutrittskontrolle. Damit stellt diese Kategorie eine deutliche Verbesserung bei kleinen Unternehmen dar.

Betriebssicherheit

... gegen technische Störungen. Einschließlich sicherer Archivierungsoptionen.

Die Standards von Service-Rechenzentren sind klimatisierte, USV-gesicherte Server-Räume, die meist über IT-gerechte Löscheinrichtung und Zutrittskontrolle verfügen. Auch schnelle, redundante Anbindungen an das Internet ist zu erwarten. Oft bestehen bereits im Standard Sicherungsverfahren, die eine Generation der Datensicherung bereit stellt. Platten sind meist mit Raid 1 gespiegelt und liefern bereits einen hohen Grad an Zuverlässigkeit. Bedingt durch das Geschäftsmodell kann ein schneller Austausch der Hardware angeboten werden. Insgesamt übertrifft damit dies die Zuverlässigkeit vieler kleinerer Installationen. Es werden SLA-Zusicherungen gemacht, und Lösungen mit Fail-Over-IP's sind verfügbar. http://www.ovh.de/items/ip_failover.xml

Wenn der Standard hinsichtlich Ausfall-Szenarien und Band-Sicherungen nicht genug sind, kann in der Regel weitere Verfahren einplanen. Allerdings ist zu fragen, wie hoch die Anforderungen vom Geschäftsprozess wirklich sind, und in welchem Verhältnis der Nutzen (Risiko-Minimierung) im Verhältnis zum Aufwand steht.

Es kann ferner davon ausgegangen werden, dass bei einer erhöhten Nachfrage von Enterprise Features der Preis auch für erweiterte Standard-Services im Konkurrenz-Kampf optimiert wird.

Leistung und Flexibilität

Die angebotenen Server entsprächen nicht den Anforderungen des Unternehmens.

Sicher gibt es Grenzen bei Systemen, die auf spezieller Hardware laufen - AS400, IBM Host-Systeme. Aber selbst dafür existieren Outsourcing-Angebote ... allerdings nicht in Form von kostengünstigen Standard-Service-RZ's.

Hinsichtlich der Leistungsklasse sind aber bereits viele Angebote eines modernen Standard-Servers bereits so weit, dass sie das Vermögen eines mittleren Rechenzentrums vor wenigen Jahren in den Schatten stellen. Z.B. sind auch ausgewachsene Boliden verfügbar: Intel 2x Xeon X5355 mit Arbeitsspeicher 12 GB und 5x 750 GB (2,8 TB) RAID 5 bei OVH oder Intel Xeon E5345 2x QuadCore mit je 4x2,3GHz, Arbeitsspeicher 16 GB, 4x 300 GB Festplatten, SAS 15.000 upm bei PlusServer

Konzeptionell setzt man eben nicht auf Server-Konsolidierung, sondern auf Server-Multiplizierung durch austauschbare Standard-Komponenten. Hier bestehen für viele Fälle sogar Performance-Potenziale. Allerdings werden nicht alle Anforderungen durch dieses Konzept gut bedient.

Einschränkungen bestehen vor allem bei hohem Netz-Traffic, z.B. bei File-Servern. Hier empfehlen sich weiterhin lokale Lösungen, während Dialog-Anwendungen selbst bei Hunderten von Benutzern meist unproblematisch sind.

Betreuung

Die Hauptkosten liegen im Personal, dass eben bedarfsgerecht vorzuhalten ist.

Das ist korrekt: Vor allem der große Anteil der spezialisierten Betreuungsmanschaft und lange Zeiten der Erreichbarkeit treiben die Preise. Um so mehr ist darauf zu achten, einen möglichst großen Anteil von erforderlichem Wissen und Dienstleistung, dass nicht unternehmensspezifisch ist, an günstige Drittanbieter zu verlagern. Neben den Hosting Anbietern, die durch Streamlining in einem Preiskampf bei hinreichenden Service-Leistungen stehen, positionieren sich Business-Anbieter mit Zusatz-Leistungen, die speziell Unternehmenskunden ansprechen. Beispiele: PlusServer, OVH oder HostEurope.

Es existiert ein Application-Outsourcing-Markt, der sich auf bestimmte Leistungsangebote spezialisiert hat. So ist das SAP-Outsourcing vor allem darum attraktiv, da es gerade speziellen Skill konzentriert vorhält.

Standard-RZ's liefern betriebs- und betriebssystem-spezifische Dienste, die keineswegs Unternehmensspezialisten dauerhaft binden. Auf diese Art lässt sich die Betreuungsaufwand reduzieren. Allerdings ist es Aufgabe, die Technik zu beherrschen und die Services zu koordinieren auf wenige Köpfe zu konzentrieren. Die Anforderungen an diese verlagern sich ... hier ist vor allem eine hervorragende Betriebsdokumentation erforderlich.

Softwarelizenzen für das Systemmonitoring

Profi-Werkzeuge sind sehr teuer.

Cornelius Zachau, Servicemanager bei TDS, einem führenden ASP und Outsourcer mit Spezialisierung auf HR und SAP, sieht noch andere Kostentreiber: Die wesentlichen Kosten beim Serverbetrieb liegen heute nicht mehr beim Personal, sondern bei den Softwarelizenzen für das Systemmonitoring. Gerade hier trennt sich dann auch die Spreu vom Weizen. Zwischen einem "ping" - mein Server ist da und einer kundenindividuellen Prozessüberwachung liegen Welten.

Dann lohnt es sich auch, hier entsprechend Arbeit zu investieren. Konform zu ITIL Best Practices sind hier viele Bereiche zu unterstützen ... siehe auch http://www.itil-blog.de/. Systems Management besteht aus vielen Komponenten. Davor zurückzuschrecken, nichts zu tun und es gegen teures Geld den Experten zu überlassen ist sicher eine Möglichkeit. Aber es geht auch anders.

- Applikationsseitig: Hier sind Testfälle bereit zu stellen, die folgenden Anforderungen genügen:

- Aussagekräftige Indikatoren über die Funktionsfähigkeit und Performance der Anwendung - und zwar funktional!

- Einschluss aller Wichtigen Komponenten, also der Kommunikation, Datenbank, Applikation Server, Funktionsmodul

- Der Test verursacht keine Störungen in den Geschäftsbetieb.

- Protokollierung des Ergebnis und der Performance

- Der Test sollte das System nur minimal belasten, um wertvolle Kapazität nicht den Anwendern zu entziehen.

- Festlegung einer vernünftigen Frequenz, z. B. 1, 10 oder 60 minütig.

- Systems Management Software: Leistungsfähige Produktfamilien erschlagen die Interessenten durch Umfang und Lizenzkosten. Bekannte Namen sind IBM Tivoli, HP OpenView, BMC Performance Manager (ehemals PATROL), NetIQ. Allerdings sind auch hier kostengünstige Alternativen denkbar, wenn man sich auf die wirklich benötigten Funktionen beschränkt und auch vor Open Source Produkten oder solchen mit geringen Lizenzkosten nicht zurück schreckt.

- Konsolen und Monitoring: Neben den o.g. Anbietern gibt es freie und kostengünstige Alternativen: Nagios, Eine freie Variante zu Big Brother von Quest gibt es hier: Big Brother ... allerdings unter der Einschränkung einer nicht-kommerziellen Nutzung. Ohne diese Einschränkung läuft Hobbit Monitor. All diese zeigen in Echtzeit den Status vieler Systeme an und eskalieren Probleme, ggf. mit email-Notifikation.

- Ticket Request Systeme und Help Desks: Ebenso relevant und unverzichtbar sind Systeme zum erfassen und Verfolgen von Anfragen / Tickets. Hier denken Profis oft an BMC Remedy oder von den o.g. Systems Management Anbietern. Aber auch hier gibt es kostengünstige Alternativen: OTRS Open Ticket Request System: Service-Management per Open Source, Zeta Helpdesk oder SysAid

- SLA-Performance-Measurement: Eine besondere Klasse sind Werkzeuge, die die Einhaltung vereinbarter Service Level überwachen. Hier ist das Markangebot insgesamt sehr dünn ...

In all diesen Bereichen sind Service-Rechenzentren bislang eher schwach vertreten. Meist existiert ein internes Ticketing System wie OTRS das aber nicht transparent in den Systembetrieb des Kunden eingebunden ist. Offensichtlich müssen Service-RZ in diesem Bereich stärker aktiv werden, um auch Firmenkunden umfassendere Angebote zu machen.

Gesetzliche Anforderungen

Sonderauflagen und Gesetze zwingen zu einer Kontrolle über die Datenhaltung.

Wenn Auflagen mit externen Dienstleistern nicht sachgerecht zu erfüllen sind, dann ist dies ein schlagendes Argument. Aber sind die gesetzlichen Anforderungen tatsächlich der Gestalt, dass diese nicht in einem Service-RZ gehalten werden dürfen? Hier wäre eine Überprüfung der genauen Aussage der Anforderung und eine Überprüfung der Service-Anbieter sinnvoll.

Psychologie

Die Unternehmensleitung möchte sehen, wo ihre sensiblen Daten stehen.

Es ist einfacher, unreflektiert Vorstellungen umzusetzen, die einem spontan nahe liegend erscheinen. Die Risiken einer bestehenden Lösung oder eines konventionellen Konzeptes werden tendenziell eher verharmlost, neue Visionen zunächst sehr kritisch eingeschätzt. Eine andere Sicht ist bei Entscheidungsträgern vor allem durch solide Informationen und harte Fakten zu installieren.

Aber auch Profis, die über alle erforderlichen Informationen verfügen, haben gewisse Aversionen, von einem eigenen Data Center weg zu denken. Einige Fragen sollten die Reflektion erleichtern:

- Welchen praktischen Nutzen haben Sie, wenn die Rechner in ihren Räumen sind?

- Sind eigene Angestellte und fremde Service-Techniker im eigenen RZ besser zu kontrollieren als die Mitarbeiter eines Service-RZ? Wie?

- In welchem Szenario ist das eigene RZ wirklich besser?

- Sind die bestehende Vorbehalte rational? Sind diese nicht auch gut lösbar?

- Haben sie sich eigentlich die Kosten und den Nutzen beider Konzepte gegenüber gestellt?

- Haben sie eine partielle Auslagerung und deren Vorteile in Betracht gezogen?

Die hier vorliegenden Informationen sollten aber bereits erkennen lassen, dass in den vorgestellten Alternativen enorme ungenutzte Potenziale liegen. Diesen sind Opportunitätskosten zuzuweisen. Die berühmten Eh-da-Kosten sind allerdings eher psychologisch, als betriebswirtschaftlich zu verstehen.

Elemente eines neuen Betriebskonzeptes

Hier soll keine Lösung für alle Probleme dieser Welt vorgestellt werden, sondern Ansätze, die in vielen Fällen neue Möglichkeiten eröffnen ... auch in einem Mischkonzept. In der Gesamtsicht wird zunächst deutlich, wie anders die Herangehensweise als die konventioneller Lösungen ist, obwohl die einzelnen Elemente sicher mehr oder minder bereits Beachtung finden - In der Summe handelt es sich allerdings um eine andere Betriebsorganisation mit innovativer Ausrichtung.

Leitlinien

- Über allem stehen die Ziele in der Gesamtsicht. Es soll vermieden werden, dass in der Detailarbeit das Gesamtziel zu Gunsten eines Detailzieles aus dem Auge verloren wird.

- Ballance zwischen Systematik und Pragmatik.

- Zuviel an Systematik erstickt die notwendige Dynamik, schafft einen unerwünschten administrativen Overhead und ist dadurch kontraproduktiv.

- Zuviel an Pragmatik führt zum Chaos und unwartbarem Dickicht, dass später kaum noch durchschaut werden kann und Risiken und Mehraufwand verursacht.

- Chancen nutzen! Technologische und Markt-Entwicklung bieten Möglichkeiten, die auch genutzt werden können und sollen.

- Keine Panik. Änderungen sind unvermeidlich, wenn Verbesserungen erzielt werden sollen. Diese sollten kritisch und mit gezielter Planung begleitet werden. Hast oder Blockade sind keine guten Strategieen.

- Embrace the Change. Neues wagen! vielmehr positiv zu den Chancen stehen, und diese unter Beachtung der Risiken aktiv angehen.

- Migrationspfade beachten. Neue Konzepte mögen sinnvoll sein, der Weg dort hin wird kein leichter sein ...

- Dokumentation: So viel wie nötig, so wenig wie möglich! Dokumentation kostet Aufwand und ist oft genug veraltet oder nicht auffindbar. Auch hier gilt, dass ein knapper aktueller Verweis, der von den Betroffenen Gefunden wird, wesentlich mehr wert ist, als eine formal und inhaltlich vollkommene Dokumentation, die aber nicht gefunden wurde, wo sie benötigt wurde.

- Wenn etwas in der Branche den Hype hat, dann kann es auch sinnvoll sein, muss es aber nicht. Darum sind Trends nicht deswegen zu folgen, weil sie da sind, sondern können befolgt werden, wenn sie plausibel die Gesamtziele unterstützen.

Requirements Management

Irgendwie wissen alle, dass IT kein Hobby ist, sondern eine betriebswirtschaftliche Notwendigkeit. Zuweilen werden Anforderungen auch explizit diskutiert, meist recht pragmatisch. Die Systematik bleibt auf der Strecke. Auch bei stark strukturierten Prozessen wird den Anforderungen oft ein Informeller Charakter zugewiesen. Die Formulierung von Anforderungen ist oft Spielwiese für politisches Geschick. Das eigene Interesse führt dazu, die Anforderungen hoch zu schrauben ... manchmal mit dem Hintergedanken, dass dann auch masse für Kompromisse da ist. Derartige politische Lösungen sind jedoch von dem Geschick Einzelner stärker abhängig als von Sachlichen Notwendigkeiten. Das kann nur zu mehr oder minderer Deallokation von Ressourcen führen.

Sinnvoller ist die Aufbereitung nach vernünftigen Bewertungsansätzen. Hier können Bewertungsansätze aus IFM übernommen werden.

Anforderungen sind aber nicht nur Teil neuer Projekte, sondern in der Vermaschung mit anderen Projekten und Betriebsthemen als zentrale Basis aller Aktivitäten zu sehen.

Auch werden dazu nicht unbedingt teure Spezialwerkzeuge benötigt, sondern ein gut Strukturiertes Konzept auf Basis eines Wiki-Servers kann bereits gute Ergebnisse liefern. Darin ist es ein Unterziel eine möglichst starke Partizipation alle Betroffenen und Transparenz der Vorgänge zu erreichen. Wenn das systematische Denken in sachgerechten Anforderungen zum Teil der Unternehmenskultur geworden ist, wird bereits viel erreicht sein. Das schließt auch die Behebung von Schwachstellen und Nutzen der Chancen ein.

Klare Anwendungsabgrenzung

Die Zuordnung zu angemessenen Kategorien ist oftmals problematisch. Sinnvoll wären hier Hierarchische oder Matrix-Organisationen, die die Verschiedenen Dimensionen mit den fachlich-technischen Begebenheiten berücksichtigt. In jedem Fall ist eine feinere Granularität, mit entsprechenden Entscheidungskompetenzen und klarem Hierarchiebau anzustreben.

Einfach ist dies nicht. Denn es muss letztlich für jede Frage eine zuständige Position bekannt sein und ein dazu gehörender Eskalationspfad. Zuständigkeiten müssen allerdings mit Ressourcen ausgestattet sein. So kann ein Mehr an Verantwortung nicht ohne Zuweisung von Arbeitszeit realisiert werden.

Im Besonderen bei Schnittstellen zwischen den Bereichen kann es zu unklaren Situationen kommen. So ist im Bereich Netzwerk-Technik / Netzwerk-Sicherheit und Server Betriebssysteme mit Zuständigkeit ein Problem. Wann soll ein Patch eingespielt werden? Bei Hunderten von Servern und Tausenden von Applications wird es dann zur Herausforderung die Koordination sachgerecht durchzuführen.

Schnitt zwischen den Verantwortungsbereichen

Wenn heute die klassische Gliederung zwischen Entwicklung, Support und Betrieb besteht, dann bildet dies zwar die Aufbau-Organisation ab, ist aber oft nicht problemorientiert und führt zu Reibungsverlusten. Hier wären oft dynamischere Strukturen sinnvoll. Im Besonderen, wenn Teile des Systembetriebes nach außen verlagert wird.

Wo greift die Präferenz von kurzen Wegen (der kleine Dienstweg) gegenüber strukturierter und hierarchieorientierter Bürokratie? Oder ist das bereits die Anstiftung zum Chaos?

Best Practices nach ITIL und Incident-Management erfordern ein zentrales Ticketing-System. Die Adressierungerouten des Incidents sind nicht nur im Kontext der SLA von Interesse. Wie nun die Kopplung der Ticketing Systeme - Intern/ ein oder mehrere Service Provider - sein wird, ist noch offener Punkt. Im Zweifel funktioniert ein manuelle Übertragung oder scriptgesteuerte, halbautomatische Lösungen.

Service Level Agreements - Testverfahren

Die andere Seite der Münze des Requirements Management ist ein gut funktionierendes Management der Service Level Agreements (SLA). Nicht nur für externe Dienstleister ist es sinnvoll, die Erfüllung der Anforderungen auch zu überwachen. Kern darin sind präzise und überprüfbare Kriterien, die allerdings realistisch angesetzt werden müssen.

Um eine entsprechende Spezifikation, vor allem über End-to-End Verfügbarkeit und Performance zu erreichen, erfordert es nicht nur über eine geeignete Systemlösung zum SLA-Measurement, sondern auch klar definierte und automatisierte Testfälle der Applikation, die die Kriterien gegen das Soll messen kann. So mag die Spezifikation und Entwicklung derartiger Testfälle zunächst als Hürde erscheinen, allerdings zahlt sich dieser Aufwand aus. Für den Betrieb, die Anwender und die Entwickler.

Mehrwert Dienste

Eine derartig entwickelte Umgebung, die neue Möglichkeiten zur verteilten Datenverarbeitung hat, eröffnet weitere Möglichkeiten zu Mehrwert-Diensten. So kann ein Dienst auf Basis eines externen assoziierten Host oder auf einem integrierten externen Unternehmensserver von einem Service-Anbieter komplett bereit gestellt werden. Diese können neben der Entwicklung und Bereitstellung der Anwendung auch Teile des Betriebes und Supports übernehmen und somit einen Schritt zur kostengünstigen Kalkulierbarkeit eines Anwendungsbetriebes ermöglichen. Stichwort: Service Oriented Architecture - SOA

Eine derartige Diversifizierung und Konkurrenzbildung zu anderen Anbietern ermöglicht auch kleinen, dynamische Unternehmen integrierte Lösungen zu schaffen. Voraussetzung sind klar definierte Schnittstellen und Anforderungen, die es Drittanbietern ermöglicht, diese Lösungen Systemkonform zu platzieren.

Application Outsourcing

... ist ein Begriff, der sich auf größere Blöcke von Anwendungen, z.B. ein komplettes SAP-R3 Betrieb verstanden wird. Die Abgrenzung zwischen Mehrwert Diensten und Application Outsourcing ist eher fließend. Letzteres bezieht sich nicht nur auf größere Einheiten, sondern auch auf eine Beziehung zwischen 2 Partnern. Neben SAP betrieb sind vor allem 'Lohn und Gehalt', Swift-Messaging oder Lettershops Kandidaten für Application Outsourcing. Mehrwert-Dienste sind eher Multi-Partner Kooperationen. Kleiner Module fügen sich wie Puzzle-Teile in eine Service-Landschaft des Kunden ein, der bereits mit einem oder mehreren Betriebspartnern zusammenarbeitet.

Beide Formen, Application Outsourcing und Mehrwert-Dienste, flexibilisieren die Kapazität und vermeiden Anwendungs-Rückstau, erfordern aber höhere Koordinations- und Integrationsleistungen.

Client Outsourcing

Die Auslagerung des Service Help Desks finden in einigen Konzernen bereits statt. Externe Dienstleister stellen das User Help-Desk und haben Zugriff auf die einzelnen PC's (Remote Desktop, NetOp, Netviewer, VNC oder Online Services.

Gepaart ist dieser Trend mit dem Einsatz von Windows Terminal Services (WTS) und Citrix. Hierbei läuft die Anwendung nicht mehr auf dem localen PC, sondern auf einem entfernten Server. Auf diesem ist die Bereitstellung der Installationen, incl. Lizenzverwaltung, Konfiguration, Problembehandlung und Datenhaltung oft einfacher zu machen. Dies ganze läuft dann entweder als bildfüllende Anwendung auf einem Windows-Terminal, in einem Windows-Fenster oder in einem Browser-Fenster.

Unternehmens IT-Koordination

Aus den bisherigen Ausführungen wird deutlich, dass die Organisation von IT-Abteilungen sich weg bewegt von der klassischen Gliederung Betrieb, Support, Entwicklung, hin zum Requirements Management, SLA-Koordination und Integrations-Dienstleister. Manche Formen haben sich bereits über bestimmte Formen von Anwendungen und Service-Verträgen so eingeschlichen. Allerdings geschieht dies jenseits der Management -Wahrnehmung und eher Fall-orientiert als systematisch.

Darum wäre ein konzeptioneller Umbau und Selbstverständnis als Service-Koordinator mit geeigneten Verfahren die Aufgabe der Zukunft.

Migration und Co-Existenz

Offensichtlich können diese Verfahren nicht auf der grünen Wiese entwickelt werden, auch ein Big Bang in der Umstellung scheint ausgeschlossen. Letztlich erscheint auch ein vollständiges Outsourcing von zentralen Rechenleistungen auch langfristig nicht sinnvoll, denn File-Server und ähnliche High-Traffic-Anwendungen sollten besser im Unternehmensnetz lokal bleiben.

Wird dadurch das Konzept hinfällig? Keineswegs, denn der Nutzen liegt nicht erst in der vollständigen Umsetzung, sondern sollte sich jeweils auf der Applikationsebene bemerkbar werden. Es bliebe dann lediglich ein Rumpf von internen IT-Komponenten bestehen, der aber spürbar ausgedünnt ist. Ein langsamer Migrationspfad ermöglicht ferner, die Erfahrungen mit dem Konzept risikoarm aufzubauen und sukzessiv zu steigern, bis sich ein optimiertes Gleichgewicht einstellt.

Ein Hybrid-Konzept erscheint vielen wenig nahe liegend. Meist denken Menschen: Ganz oder gar nicht!

Dabei wäre das aber gerade äußerst nützlich. Erstaunlicher Weise verlager man Rechenzentren eher nach Rumänien, um vermeintliche Kostenvorteile zu nutzen - trotz erheblicher Risiken - als das man moderene Service-Geber bei Risiko-Minimierung einbezieht. Denn die Kosten liegen oft in der Menge der Server und der suboptimalen Organisation, weniger im Stundensatz der Mitarbeiter.

Die halbherzige Umsetzung des Konzeptes ohne den Aufbau der entsprechenden organisatorischen Infrastruktur dürfte allerdings bestenfalls einen Nutzen bringen, der weit hinter den Möglichkeiten zurück bleibt. Vielmehr ist ein Commitment der Entscheidungsträger zu diesem Kurs sinnvoll.

Fazit

Durch technisch-organisatorischen Wandel - hier: Angebote von Service-RZ - entstehen neue Chancen und Möglichkeiten, die bei konsequenter Umsetzung ein enormes Potential der Verbesserung, Flexibilisierung und Kostensenkung ergeben. Durch einsatz recht kostengünstiger und freier Software, die bereits einen hohen Leistungsumfang hat, kann IT in Unternehmen mit weit geringerem Aufwand und dennoch hoch funktional betrieben werden.

Erst durch eine konzeptionelle Durchdringung und Neupositionierung werden diese Chancen zu echtem Nutzen. Beratungsangebote können hier die Position identifizieren und sachgerechte Entscheidungen vorbereiten.